Описание Этапов Эволюции "Astro-Algo"

Введение: От Идеи к Самообучающейся Системе

Проект "Astro-Algo" представляет собой не просто продукт, а живую, эволюционирующую аналитическую экосистему. Каждый этап ее развития был ответом на фундаментальные ограничения предыдущего, последовательно превращая систему из простого поисковика в полноценный "Движок для Генерации Инсайтов", способный к автоматизации экспертизы.

Этап 1: "Умный Поиск" — Гибридный RAG

Ключевая Проблема: "Семантический разрыв" и нестабильность. Изначальная RAG-система часто "молчала", так как не могла найти в своей базе знаний (Weaviate) документы, если пользователь был сформулирован немного иначе, чем текст в кейсах. Ответы были непредсказуемы, а отладка — затруднена.

Реализованная Технология:

-

Стабилизация Инфраструктуры: Была проведена ревизия и отладка

docker-compose.yml, решены проблемы с конфликтами портов, сетевым взаимодействием между контейнерами и зависимостями внутри образов. -

Калибровка Векторного Поиска: Централизована и откалибрована ключевая настройка

WEAVIATE_CERTAINTYв.envфайле, что позволило добиться стабильного нахождения релевантных документов. -

Внедрение HyDE (Hypothetical Document Embeddings): Был добавлен специализированный

hyde_agent. Вместо того чтобы искать по вектору "сырого" вопроса, система теперь сначала генерирует с помощью LLM гипотетический, идеальный ответ на этот вопрос, и уже по его, семантически богатому, вектору производит поиск.

Достигнутая Возможность: Система научилась стабильно отвечать на вопрос "Что?" ("Что в моем 'Золотом архиве' говорится о похожих ситуациях?"). Поиск стал устойчив к синонимам и разным формулировкам, преодолев "семантический разрыв". Мы получили надежный фундамент для дальнейшего развития.

Итог: Система достигла уровня продвинутого, надежного RAG-решения, готового к переходу от простого поиска к сложному анализу.

Этап 2: "Экспертный Конвейер" — Агентная Архитектура

Ключевая Проблема: RAG — это "говорящая библиотека". Она может найти и пересказать книгу, но не может провести исследование. Системе не хватало методологии, способности следовать сложному плану анализа и "заземления" в объективных данных.

Реализованная Технология:

-

Агент-Оркестратор (

main.py): Ядро системы было переписано по принципу Оркестратора. Оно перестало быть монолитным и превратилось в управляющий центр, запускающий последовательность специализированных агентов. -

Специализированные Агенты (

astro_agents.py): Появились первые "эксперты" —core_algo_agentдля применения уникальной астро-методологии иhistory_agentдля сравнительного анализа найденных кейсов. -

Интеграция с Внешними Данными (

market_data_agent): В конвейер был добавлен агент, подключающийся к внешним API (Yahoo Finance) для получения реальных рыночных котировок.

Достигнутая Возможность: Система эволюционировала в симулятор экспертной работы. Она теперь не просто ищет, а анализирует, следуя многошаговому процессу: найти аналог (RAG) → применить методологию (core_algo) → сравнить с историей (history) → сопоставить с фактом (market_data). Система научилась отвечать на вопросы "Как?" (Как прийти к выводу?) и "Насколько точно?" (Как прогноз соотносится с реальностью?).

Итог: Проект перешел из категории "Информационный ассистент" в категорию "Аналитическая Платформа".

Этап 3: "Карта Связей" — Граф Знаний

Ключевая Проблема: Даже с агентным конвейером система все еще оперировала "мешками слов" — неструктурированными текстами. Она не могла видеть фундаментальные, нелинейные связи между сущностями (планетами, компаниями, датами, событиями), если они не были явно описаны в одном документе.

Реализованная Технология:

-

Внедрение Графовой Базы Данных (

Neo4j): Был развернут и интегрирован сервер графа. -

Строитель Графа (

graph_builder.py): Создан отдельный, изолированный сервис-задача, который читает структурированные.jsonфайлы и строит из них "Карту Связей" — узлы и ребра вNeo4j. -

Микросервис Запросов (

graph_query_proxy): Для решения проблемы конфликта зависимостей (openai v0.28 vs v1.x) был создан независимый микросервис.rag_proxyтеперь не общается с графом напрямую, а делает HTTP-запрос к этому специализированному "эксперту по графу".

Достигнутая Возможность: Это фундаментальный скачок от анализа текстов к структурированному пониманию. Система научилась находить скрытые, многошаговые причинно-следственные связи. Она теперь может логически вывести, что [AAPL] связан с [Марсом] через цепочку [Дата основания] → [Знак Овна] → [Управитель]. Система впервые смогла ответить на самый главный вопрос: "ПОЧЕМУ?".

Итог: "Аналитическая Платформа" превратилась в "Движок для Генерации Инсайтов" (Insight Generation Engine), создав уникальное конкурентное преимущество.

Этап 4: "Живые Знания" — Автоматизация Экспертизы

Ключевая Проблема: "Движок Инсайтов" был невероятно мощен, но его "топливо" (данные для графа) приходилось создавать вручную, долго и кропотливо превращая экспертные знания в жесткие .json файлы. Это узкое место мешало масштабированию.

Реализованная Технология:

-

Создание Собственного "Движка Извлечения": Вместо проблемных внешних библиотек был разработан собственный, современный инструмент на основе

tool callingв новейших моделях OpenAI (таких какgpt-5-mini). -

Схемы как Код (

Pydantic): Вместо написания парсеров для каждого типа данных, мы теперь описываем желаемую структуру в виде простых и понятных Pydantic-схем. -

Интеграция в

graph_builder.py: "Строитель Графа" был кардинально переработан. Теперь он не читает.json, а "скармливает" любой сырой текст (например, ваш экспертный кейс999.md) "Движку Извлечения", который автоматически превращает его в идеально структурированные данные, готовые к загрузке в граф.

Достигнутая Возможность: Мы автоматизировали самый сложный этап — превращение неструктурированной экспертизы в структурированные знания. Теперь один и тот же экспертный .md файл служит "пищей" и для RAG-поиска (контекст и аналогии), и для автоматического обогащения Графа (точные факты и связи). Система научилась самостоятельно поглощать и структурировать знания.

Итог: Система достигла уровня "Платформы по Автоматизации Экспертизы" (Expertise Automation Platform). Она не просто использует знания — она создает их, обучаясь на текстах, которые вы ей предоставляете. Это открывает путь к практически безграничному масштабированию вашей уникальной аналитической методологии.

Этап 5: "Адаптивный интеллект"

- Цикл экспертной обратной связи

Это переход от системы, которая просто выполняет заложенные в нее алгоритмы, к системе, которая обучается и адаптируется, становясь со временем все более точным и персонализированным инструментом. Она учится на вашем опыте и вашей оценке.

- Аналогия: Если раньше у вас был талантливый, но неопытный аналитик, которому вы давали четкие инструкции (протокол), то теперь вы становитесь его наставником. Вы проверяете его работу, указываете на сильные и слабые стороны, и со временем он начинает "думать" так, как вы, и предвосхищать ваши ожидания.

- Цель: Качественно улучшить результаты всех предыдущих этапов (с 1 по 4), настроив выводы системы так, чтобы они максимально соответствовали вашему экспертному видению и стилю анализа.

Как это работает (Улучшенный Цикл обратной связи):

-

Анализ и "Вечный Якорь": Система, как и прежде, выполняет полный анализ по запросу. Но теперь в конце каждого ответа она генерирует не просто ID, а готовый шаблон для обратной связи. Этот

ref_id— это вечная ссылка на полный "слепок" всего аналитического процесса (какие кейсы были найдены, что вернул граф и т.д.), который надежно сохраняется в базе данных PostgreSQL. Спешить больше не нужно — вы можете дать оценку отчету в любой удобный момент. -

Экспертная Оценка: Вы, как эксперт, спокойно изучаете отчет. Когда вы готовы, вы копируете предложенный шаблон и даете оценку по вашей шкале от 1 до 5, добавляя комментарий.

- Формат команды:

##ОЦЕНКА <ID> = <ЦИФРА> = <КОММЕНТАРИЙ> - - Шкала оценок: 1-Ужасно, 2-Плохо, 3-Удовлетворительно, 4-Хорошо, 5-Отлично.

- Формат команды:

-

Сбор "Опыта":

rag_proxyперехватывает вашу команду, находит поref_idсоответствующую запись в базе данных и обновляет ее, добавляя вашу оценку и бесценный комментарий.

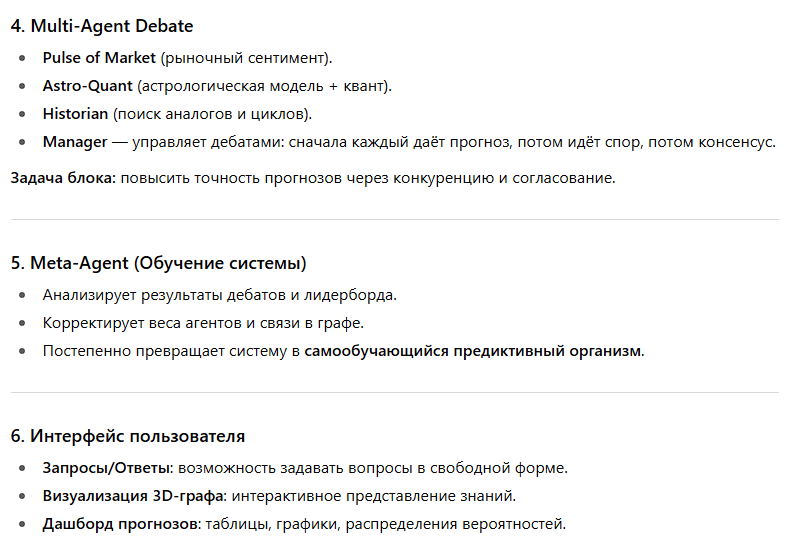

Обучение и Адаптация (Два уровня):

Накопленная база "опыта" — это не просто записная книжка, а топливо для двух типов обучения:

-

Уровень 1: Ручная доработка (Роль: Вы — Архитектор Системы). Это происходит прямо сейчас. Ваши комментарии — это конкретное техническое задание. Анализируя в базе данных отчеты с низкими оценками (1, 2), вы находите системные проблемы.

Пример: Вы видите несколько комментариев "Маркет агент не дал цену на дату". Вы понимаете, что нужно улучшить промптMarketDataAgent. Вы вносите исправление, и система мгновенно становится умнее, больше не повторяя эту ошибку. - Уровень 2: Автоматическое дообучение (Роль: AI — Ученик). Это цель на будущее. Когда вы накопите 50-100 отчетов с оценкой 5 ("Отлично"), мы сможем использовать их для fine-tuning (дообучения) базовой AI-модели. AI изучит эти "золотые" примеры и научится генерировать отчеты в вашем уникальном стиле, с вашими акцентами и логикой.

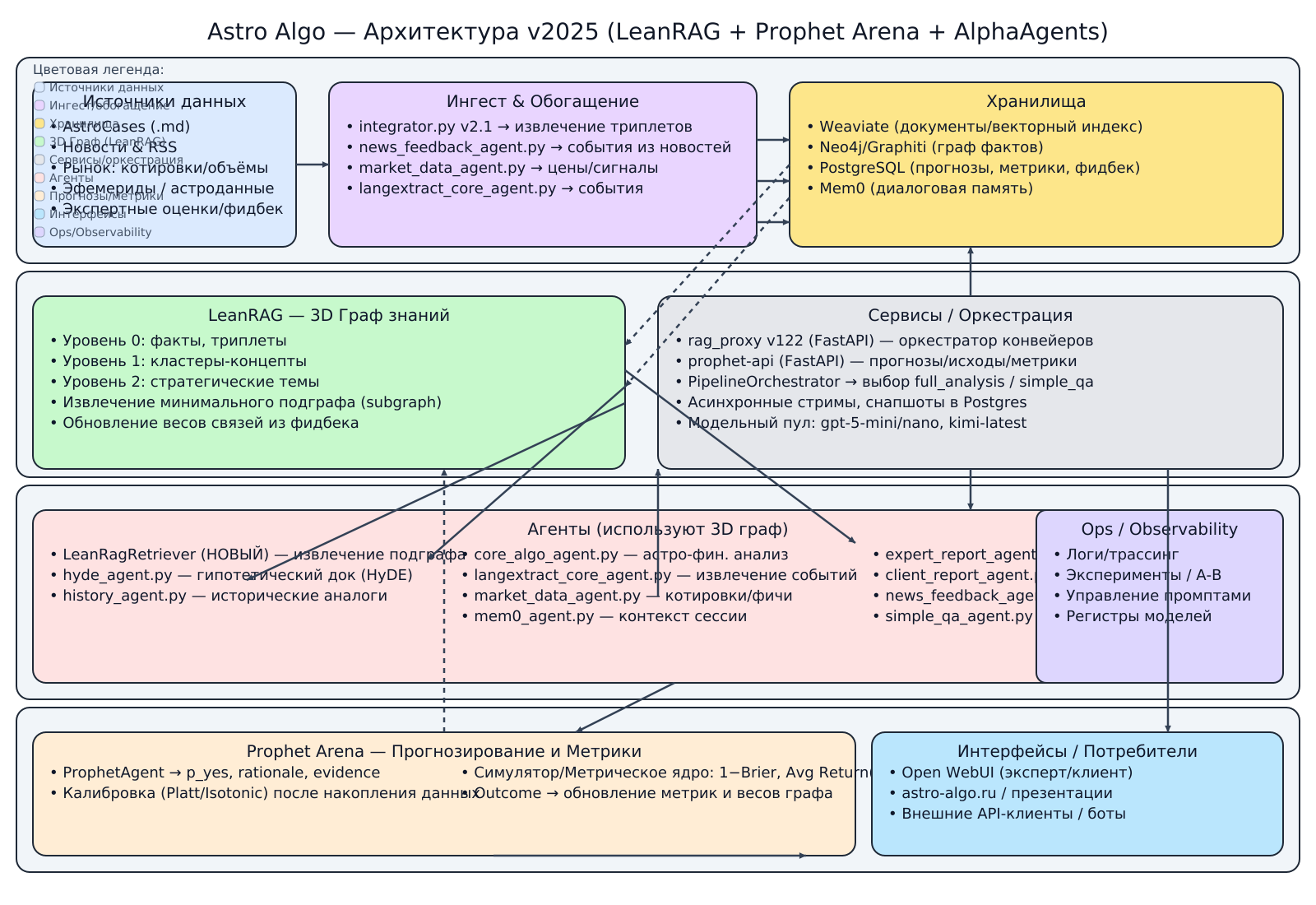

ДОРОЖНАЯ КАРТА

Переходим к финальной стадии развития проекта — построению целостной, самообучающейся экосистемы.

План ниже описывает этапы создания, а дальше - схема архитектуры 2025 — то, как все компоненты будут работать вместе.

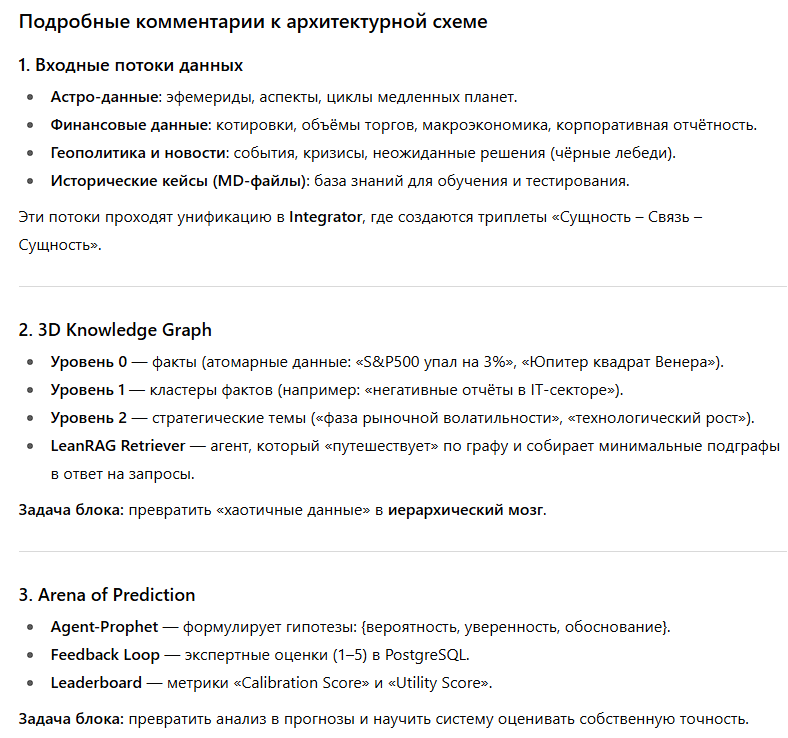

❇️ Этап 6. LeanRAG -> 3D Граф Знаний

На этом этапе строим центральный компонент нашей архитектуры — «живой мозг» системы. Это будет не статичная база данных, а динамическая, самообучающаяся структура, способная адаптироваться на основе новой информации и обратной связи.

❇️ Этап 7. Prophet Arena

Здесь создаем компонент, который превратит аналитические выводы "мозга" в измеряемые, проверяемые прогнозы. Мы запустим конвейер по их объективной оценке и калибровке, чтобы система научилась понимать свою точность.

❇️ Этап 8. AlphaAgents

На финальном этапе формируем команду ИИ-агентов для проведения дебатов. Это позволит системе приходить к более взвешенным и устойчивым выводам, реализуя самую продвинутую часть нашей архитектуры — коллективный разум.

По завершении дорожной карты,

ALGO система примет следующий вид:

Архитектурная схема системы Astro Algo

Эта схема иллюстрирует, как все описанные этапы соединяются в единую, самообучающуюся экосистему.

Эта архитектура представляет собой замкнутый цикл, где данные превращаются в знания, знания — в прогнозы, прогнозы проходят проверку, а результаты проверки улучшают исходные знания.

Проект 💥 ОБНОВИЛСЯ 💥 => FUTURE

🚀 ASTRO 💙 ALGO